Del mismo modo que la inteligencia artificial (IA) está ayudando a muchas empresas y profesionales a ser más productivos, sus avances también proporcionan nuevas «armas» a los ciberdelincuentes que intentan vulnerar las medidas de seguridad de particulares y compañías de todos los tamaños. Correos falsos cada vez más creíbles, identidades fake y suplantaciones son algunos de los próximos retos para los que hay que prepararse.

Solicita una propuesta personalizada de ciberseguridad

En esta lista de potenciales riesgos de ciberseguridad crecientes entran en juego varios factores:

- El surgimiento y mejora de nuevas técnicas de IA que hasta ahora se habían explotado poco, como los modelos grandes de lenguaje (LLM, como ChatGPT).

- La popularización de la IA entre el público general y su bajo coste.

- El crecimiento y mejora exponencial que experimentan con el tiempo.

Y en cuanto a las formas que pueden tomar están:

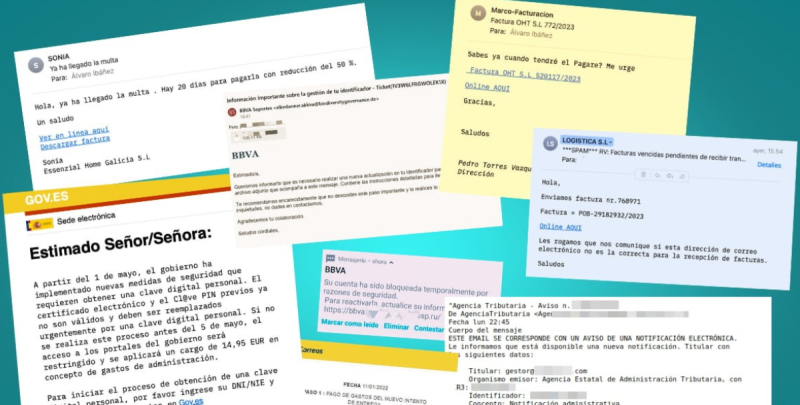

- Textos falsos pero creíbles: mensajes SMS/WhatsApp, correos, noticias…

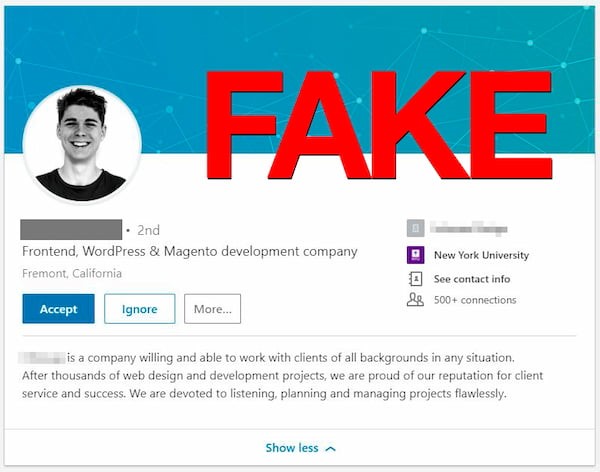

- Imágenes falsas: robo de identidades, deep fakes, disputas legales.

- Falsificación de voces: acceso a sistemas, engaños, desinformación.

- Vídeos generados por IA: deep fakes, suplantación, desinformación.

Las IA de última generación como ChatGPT, Bard, Midjourney o Muse –por mencionar algunas– son capaces de generar todo tipo de contenidos creíbles que muchas personas tienen dificultades para distinguir de mensajes, imágenes o vídeos reales. Y cuando se aplican «para hacer el mal» pueden llegar a suponer un riesgo importante.

Técnicas avanzadas de Ingeniería Socia «Automatizada»

Una IA que examine la web de una empresa es capaz de extraer los nombres y cargos de quienes trabajan allí (y de sus cuentas de LinkedIn, Twitter, etcétera) para establecer relaciones y saber quién es quién. A partir de ahí es más fácil «afinar el tiro» de cara a enviar mensajes de phising o spear phising, que no son sino versiones personalizadas de estos engaños para aumentar las probabilidades de que sean considerados auténticos, la persona haga clic y abra el malware. Los objetivos favoritos de los ciberdelincuentes suelen ser los departamentos de contabilidad y finanzas, los auditores y los consultores externos, porque manejan datos confidenciales. Es habitual que falsifiquen identidades o contacten con personal de bajo nivel en busca de información relevante a más alto nivel.

En un reciente videotutorial, el experto en IA Carlos Santana (@DotCSV) muestra cómo crear voces clonadas, algo que cuesta unos pocos dólares y en el que se utiliza una IA especializada en la voz humana de ElevenLabs junto con GPT-4 para comprender preguntas y responderlas con una voz inquietantemente bien imitada a partir de un entrenamiento de unos pocos minutos. La demostración, paso-a-paso, no tiene desperdicio.

Una versión más avanzada, pero usando vídeo, es lo que vemos todas las semanas en programas de televisión de imitaciones humorísticas y en anuncios publicitarios: personas que no son quienes parecen ser moviéndose y hablando de forma completamente creíble. En su forma simplificada y mejorada se utilizan para dar más credibilidad a la estafa del CEO (whaling), en la que se hace creer a alguien de la empresa que está hablando con «el jefe», que pide una transferencia de dinero fuera de lo habitual con alguna buena excusa.

La situación actual que hay que entender es que estas herramientas, incluyendo las de imágenes y vídeo, ya no son carísimos sistemas al alcance de unos pocos, sino software gratuito o con un coste muy bajo, que cualquiera con unos pocos conocimientos puede poner en marcha y además en poco tiempo.

Para evitar todas estas amenazas lo mejor es estar alerta, mantenerse al día sobre todas estas técnicas actuales de ingeniería social y tomar todas las precauciones posibles.

Solicita asesoramiento tecnológico personalizado

Ataques técnicos más sofisticados

Usando las IAs apropiadas, el malware que utiliza técnicas de IA para atacar a las organizaciones puede tener cierta capacidad de adaptación cuando se encuentra con medidas de seguridad que le impiden introducirse fácilmente a través de las defensas. Un ejemplo que suelen usar como ejemplo los expertos es cómo en vez de utilizar patrones repetitivos de ataque un malware equipado con IA puede camuflarse más fácilmente como intentos reales de entrar en un sistema, simulando ser un usuario humano, variando la frecuencia de los intentos y otros factores.

Otro problema en las organizaciones que ya usan IAs puede ser la saturación de los sistemas de IA por métodos relativamente sencillos. Estos sistemas pueden ser biométricos (reconocimiento facial, de voz, llaves de seguridad) y los atacantes pueden ingeniar formas de bloquearlos de modo que dejen de funcionar y acaben inutilizando desde servidores a maquinaria o medidas de seguridad físicas (puertas, etc.) causando un prejuicio. Hay un amplio abanico de técnicas adversariales, inyección de instrucciones falsas y similares que son un un nuevo tipo de ataques nada habitual.

Estar al día es importante

A todo el mundo le conviene estar informado, pero en el caso de la ciberseguridad y las nuevas amenazas es más conveniente que nunca estar al tanto de todo lo que se cuece en nuevos campos tecnológicos. Y el de la inteligencia artificial no es una excepción porque un mal uso de las nuevas IAs supone riesgos especialmente graves que específicamente pueden poner en jaque a muchos sistemas.

Enviar una respuesta

No hay comentarios